draft - 空間可視化における Gemini とGPT(チャピィ)の差

今回のRRX可視化で見えたのは、能力差というより

アウトプット設計パイプラインの違いだった。

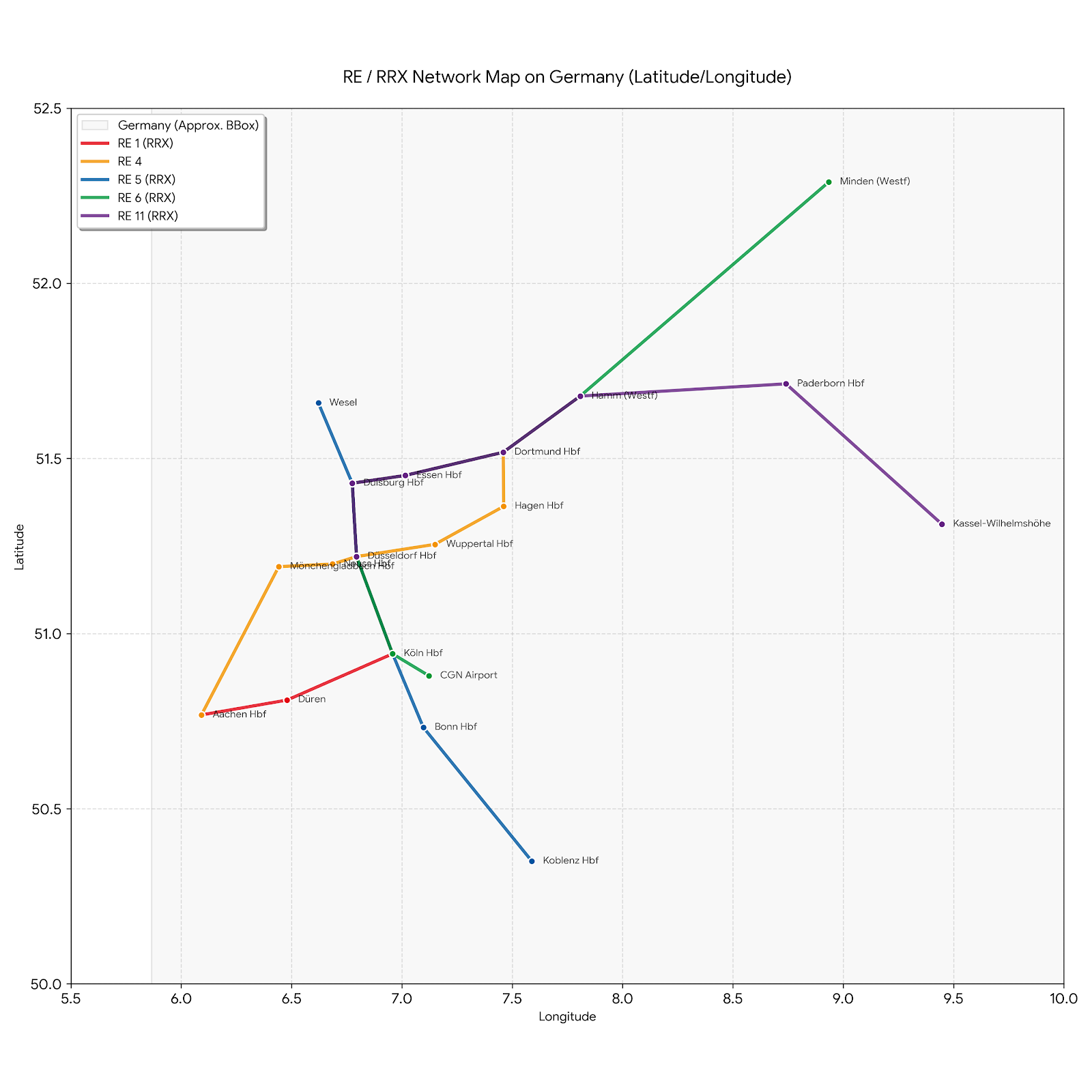

Geminiの挙動(観測)

- 座標取得:できる

- 投影変換:できる(EPSG:3857など)

- 描画:できる

ただし流れは一貫して:

要求 → 最短実装 → 出力

結果として:

- 緯度経度プロット

- 投影座標のXY散布図

- Google Mapピン

など、

「技術的に正しいが、人間的に地図にならない」

アウトプットに落ち着く。

Geminiにとって:

- 座標 = データ

- 地図 = UI(Google Maps)

という扱いになっている。

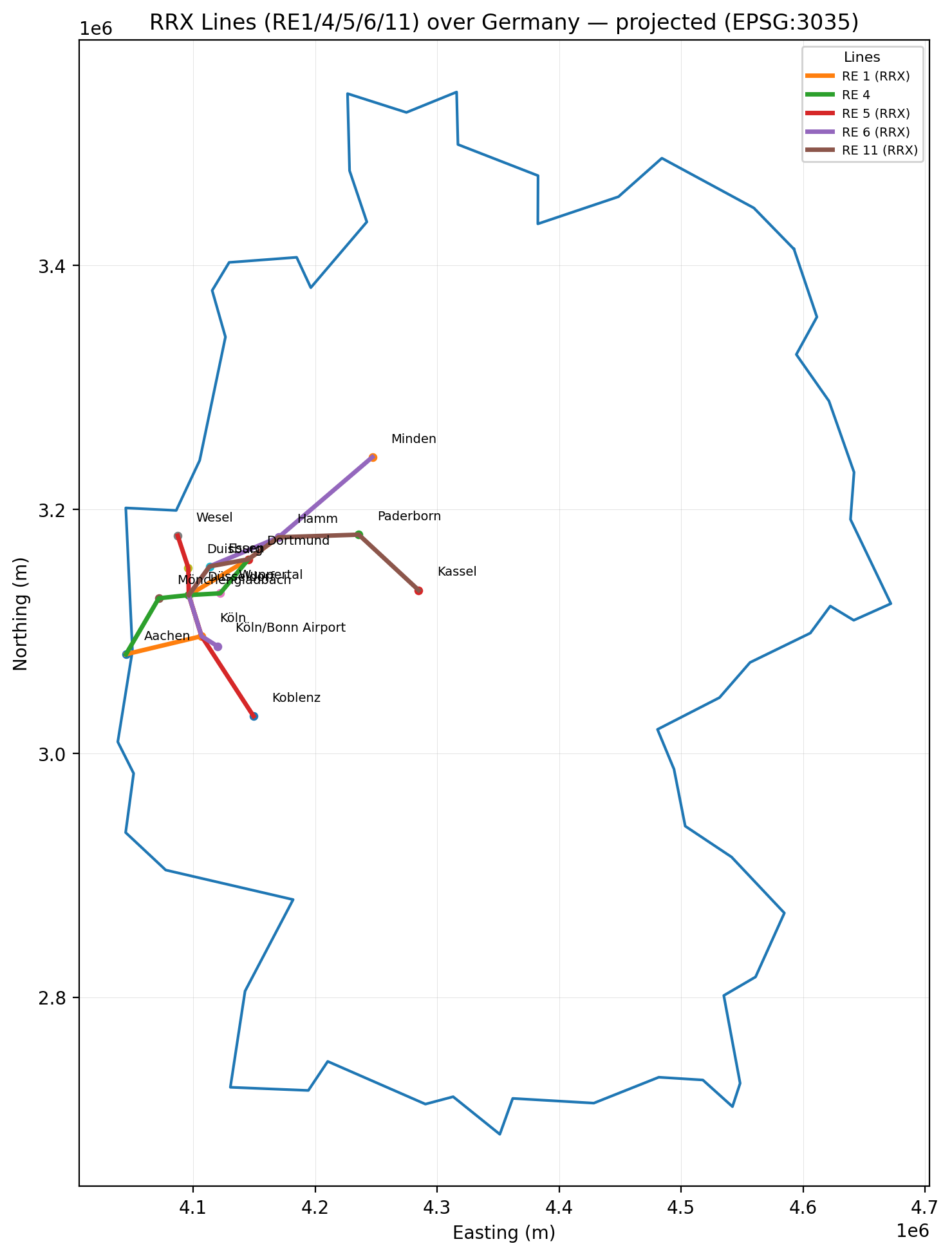

チャピィ側の挙動

同じ要求に対して:

- 投影を入れる

- 国境ポリゴンを重ねる

- aspectを固定する

- 路線をレイヤとして重畳する

という

要求 → 人間の空間認知を想定 → 構造化 → 出力

の流れを踏む。

つまり:

- 座標 = 空間

- 地図 = 幾何構造+文脈

として扱っている。

決定的な差

Gemini:

正しく描いたか?

チャピィ:

人間に“地図”として伝わるか?

ここ。

Geminiは「計算タスクとして完結」

チャピィは「認知タスクとして完結」

面白い副産物

Geminiは最終的に:

- My Maps用CSV

- Google Mapピン

という実務導線を提示してきた。

これは

可視化を外部UIに逃がす

というGoogle的アプローチで、

実用面ではかなり強い。

一方チャピィは:

内部で構造を再構成して図を生成

研究・構造理解寄り。

暫定まとめ

これは優劣というより役割分化:

- Gemini:使わせるAI(UI連携・永続)

- チャピィ:考えさせるAI(構造化・空間再構成)

そしてユーザー側が

「構造図」と「実用マップ」を分けて使い始めた瞬間、

比較はAI性能ではなくワークフロー設計になった。

著:霧星礼知(min.k)/構造支援:ChatGPT GPT-5.2/AI-assisted / Structure observation